Để Luật Trí tuệ nhân tạo có tính khả thi khi đi vào cuộc sống

Tại Việt Nam, trí tuệ nhân tạo (AI) được xác định là một trong những công nghệ ưu tiên, đóng vai trò then chốt trong chuyển đổi số, phát triển kinh tế tri thức và nâng cao năng lực cạnh tranh quốc gia. Tuy nhiên, sự phát triển nhanh của lĩnh vực này cũng đặt ra nhiều thách thức, đòi hỏi phải có hành lang pháp lý phù hợp.

Trao đổi với phóng viên, ông Đậu Anh Tuấn - Phó Tổng Thư ký kiêm Trưởng Ban Pháp chế Liên đoàn Thương mại và Công nghiệp Việt Nam (VCCI) cho rằng, việc tạo hành lang pháp lý phù hợp để khai thác hiệu quả nguồn lực AI có thể giúp Việt Nam đạt được mục tiêu trở thành quốc gia phát triển có thu nhập cao vào năm 2045.

|

| Nguồn: FPT Software. Đồ họa: Phương Anh |

Để Luật Trí tuệ nhân tạo thực sự đi vào cuộc sống và trở thành động lực phát triển, theo ông Đậu Anh Tuấn, trước tiên, luật cần bảo đảm sự linh hoạt và thích ứng trong khung pháp lý. AI là lĩnh vực thay đổi nhanh, việc luật hóa cần đi kèm với cơ chế cập nhật, thử nghiệm và phản hồi chính sách hiệu quả. Nếu quá cứng nhắc sẽ bóp nghẹt sáng tạo. Đặc biệt, cần giảm tối đa rào cản hành chính cho doanh nghiệp, nhất là doanh nghiệp nhỏ và startup; các yêu cầu đánh giá sự phù hợp, đăng ký, công bố... cần rõ ràng, minh bạch và có lộ trình hợp lý.

Đánh giá việc triển khai Cổng thông tin điện tử một cửa là điểm sáng, nhưng ông Đậu Anh Tuấn lưu ý, cần đi kèm quy trình đơn giản, minh bạch và thực sự phục vụ doanh nghiệp. Phó Tổng Thư ký VCCI cho hay, EU, Mỹ, Trung Quốc hay Singapore đều theo đuổi các mô hình riêng, nhưng điểm chung là tạo hành lang pháp lý đủ an toàn để đổi mới và đủ minh bạch để kiểm soát rủi ro.

Từ kinh nghiệm quốc tế, Việt Nam cần chọn con đường phù hợp với mình: nhanh nhạy, nhưng không liều lĩnh; khuyến khích sáng tạo, nhưng không bỏ ngỏ trách nhiệm. Trong đó, cần xác định rõ trách nhiệm pháp lý, đặc biệt trong chuỗi giá trị AI - từ nhà phát triển, nhà cung cấp đến người triển khai. Theo ông Tuấn, dự thảo Luật Trí tuệ nhân tạo đề xuất trách nhiệm pháp lý khách quan với hệ thống rủi ro cao là phù hợp, nhưng cần làm rõ cơ chế bảo hiểm, giới hạn trách nhiệm và tiêu chí phân bổ rủi ro một cách hợp lý và thực thi được.

| Theo Bộ Khoa học và Công nghệ (cơ quan chủ trì xây dựng dự thảo Luật Trí tuệ nhân tạo), nếu được Quốc hội thông qua, luật này sẽ có hiệu lực thi hành từ ngày 1/1/2026. Trong 6 tháng kể từ ngày luật có hiệu lực, sẽ thành lập, kiện toàn Ủy ban Quốc gia về trí tuệ nhân tạo; ban hành văn bản hướng dẫn; đưa Quỹ Phát triển trí tuệ nhân tạo quốc gia vào hoạt động... |

Từ góc nhìn của chuyên gia công nghệ, ông Nguyễn Tử Quảng - CEO Bkav nêu quan điểm, Luật Trí tuệ nhân tạo nên được xây dựng như một đạo luật khung, tập trung thúc đẩy sự phát triển của AI với các hướng dẫn tự nguyện; còn việc xử phạt sẽ áp dụng theo các luật hiện hành, thay vì tăng thêm các chế tài mới trong lĩnh vực này. "Việt Nam không nên đi theo mô hình luật cứng như EU, mà nên học hỏi mô hình của Nhật Bản" - ông Quảng khuyến nghị.

Còn theo luật sư Nguyễn Tuấn Linh - Công ty Luật quốc tế BMVN, Việt Nam đang có cơ hội lớn trong phát triển AI, nên Luật Trí tuệ nhân tạo cần được xây dựng dựa trên cách tiếp cận công bằng, cởi mở, tránh quy định quá nặng nề, hạn chế sự phát triển của AI. Việc đánh giá rủi ro từ AI cần dựa trên tiêu chí rõ ràng, khách quan và theo chuẩn quốc tế.

Quy định rõ hơn quyền lợi, trách nhiệm của bên phát triển AI

Luật Trí tuệ nhân tạo khi được Quốc hội thông qua sẽ là công cụ quản lý, nền tảng để Việt Nam vươn lên thành trung tâm đổi mới sáng tạo trong khu vực về AI, nơi mà doanh nghiệp Việt có thể phát triển những giải pháp công nghệ Made in Vietnam, phục vụ người Việt và vươn ra toàn cầu.

Một trong những vấn đề được các chuyên gia pháp luật và doanh nghiệp công nghệ thông tin quan tâm góp ý và mong muốn được hoàn thiện trong Luật Trí tuệ nhân tạo là quyền lợi, trách nhiệm của bên phát triển AI.

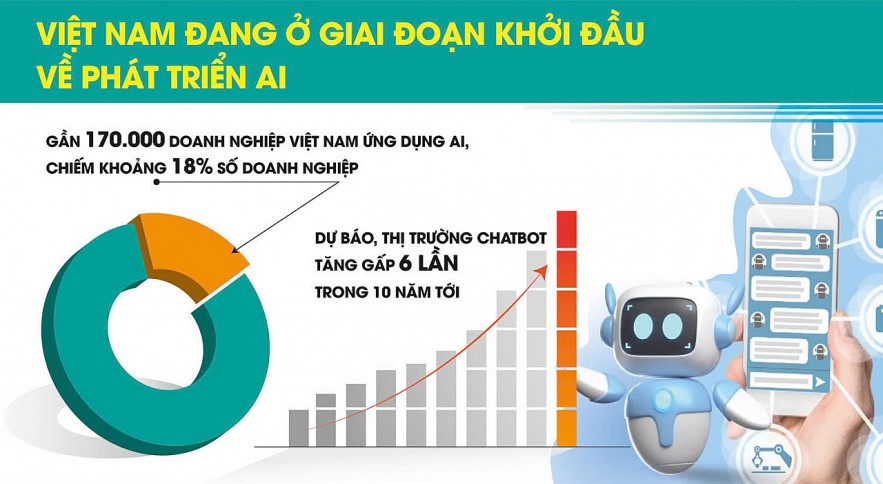

Theo bà Trần Vũ Hà Minh - Cố vấn trưởng về AI có trách nhiệm của FPT Software, Việt Nam đang ở giai đoạn khởi đầu về phát triển AI, nên có "cơ hội vàng" để xây dựng hệ thống AI tuân thủ các chuẩn mực cao. Ước tính, hiện có gần 170.000 doanh nghiệp Việt Nam ứng dụng AI, chiếm khoảng 18% tổng số doanh nghiệp; thị trường chatbot được dự báo tăng gấp 6 lần trong 10 năm tới. Vì vậy, Nhà nước cần ban hành hướng dẫn cụ thể về triển khai AI có trách nhiệm, trước hết là với các công cụ phổ biến như chatbot và trợ lý ảo.

Để Luật Trí tuệ nhân tạo có tính khả thi khi đi vào cuộc sống, bà Trần Vũ Hà Minh kiến nghị làm rõ trách nhiệm của nhà phát triển trong chuỗi cung ứng AI, thay vì chỉ quy định đối với nhà cung cấp hoặc nhập khẩu; cho phép đánh giá bởi bên thứ ba được công nhận trong nước hoặc quốc tế. Bên cạnh đó, cần định nghĩa rõ “hồ sơ kỹ thuật” và lộ trình chuyển tiếp hợp lý cho hệ thống đã triển khai trước khi luật có hiệu lực...

Với kinh nghiệm triển khai AI trên thực tế, ông Trần Văn Trí - Giám đốc truyền thông Công ty Luatvietnam.vn nhấn mạnh, điều cần thiết đối với Luật Trí tuệ nhân tạo là quy định rõ hơn quyền lợi, trách nhiệm của bên phát triển AI. Trong đó, đối với việc gắn nhãn các sản phẩm do AI tạo ra, nên quy định rõ hơn về phạm vi, mức độ phải gắn nhãn. Ví dụ, với những nội dung AI tạo ra quá đơn giản, chỉ là trợ lý cho con người, con người vẫn quyết định chính, thì nên xem lại có cần thiết gắn nhãn không. Còn với nội dung AI đưa ra, tri thức không phải của AI mà luôn gắn với một chủ thể nào đó, thì cần quy định chi tiết việc dẫn nguồn để tránh xâm phạm quyền sở hữu trí tuệ.

| Cân bằng giữa quản lý và thúc đẩy sự phát triển của AI Ông Trần Văn Khải - Phó Chủ nhiệm Ủy ban Khoa học, Công nghệ và Môi trường của Quốc hội nhấn mạnh, điều quan trọng đối với Luật Trí tuệ nhân tạo là xác định được quan điểm chính sách, xác định được điểm cân bằng phù hợp giữa quản lý và thúc đẩy sự phát triển AI. Đáp ứng yêu cầu đó, những nội dung quản lý, những điều cấm phải thật sự tường minh. Thời gian qua, nhiều nước trên thế giới đã chủ động, tích cực trong việc xây dựng, hoàn thiện hành lang pháp lý cho lĩnh vực AI. Từ kinh nghiệm quốc tế, theo ông Trần Văn Khải, Luật Trí tuệ nhân tạo điều chỉnh một chủ thể vô hình, nên sẽ tập trung quản lý những người, tổ chức sinh ra AI. Phát triển AI hiện nay có 6 nhóm rủi ro là: hành chính công, dữ liệu cá nhân, đạo đức và trách nhiệm, an toàn mạng, việc làm và lao động, giáo dục. Do đó, các nhà phát triển AI sẽ phải tuân thủ quy định của Luật Trí tuệ nhân tạo để tránh các rủi ro về kinh tế, đạo đức, an ninh, an toàn, vi phạm quyền sở hữu trí tuệ, thông tin sai sự thật. |